개요

자연어 이해는 텍스트 수반, 질문 응답, 의미 유사성 평가, 문서 분류 등 광범위한 다양한 작업으로 구성됩니다. 레이블이 지정되지 않은 대규모 텍스트 말뭉치는 풍부하지만 이러한 특정 작업을 학습하기 위한 레이블이 지정된 데이터는 부족하므로 차별적으로 훈련된 모델이 적절하게 수행하기가 어렵습니다. 우리는 레이블이 지정되지 않은 다양한 텍스트 모음에 대한 언어 모델의 생성적 사전 학습과 각 특정 작업에 대한 차별적인 미세 조정을 통해 이러한 작업에 대한 큰 이득을 실현할 수 있음을 보여줍니다. 이전 접근 방식과 달리 모델 아키텍처에 대한 변경을 최소화하면서 효과적인 전송을 달성하기 위해 미세 조정 중에 작업 인식 입력 변환을 사용합니다. 우리는 자연어 이해를 위한 광범위한 벤치마크에서 우리 접근 방식의 효율성을 입증합니다.

우리의 일반적인 작업 불가지론 모델은 각 작업에 맞게 특별히 제작된 아키텍처를 사용하는 차별적으로 훈련된 모델보다 성능이 뛰어나며 연구된 12개 작업 중 9개 작업에서 최첨단 수준을 크게 향상시킵니다. 예를 들어, 상식 추론(Stories Cloze Test)에서 8.9%, 질문 답변(RACE)에서 5.7%, 텍스트 수반(MultiNLI)에서 1.5%의 절대적인 향상을 달성했습니다.

1. 서론

원시 텍스트로부터 효과적으로 학습하는 능력은 자연어 처리(NLP)에서 지도 학습에 대한 의존성을 완화하는 데 매우 중요합니다. 대부분의 딥러닝 방법에는 상당한 양의 수동으로 레이블이 지정된 데이터가 필요하므로 주석이 달린 리소스가 부족한 많은 도메인에서의 적용 가능성이 제한됩니다[61]. 이러한 상황에서 레이블이 지정되지 않은 데이터의 언어 정보를 활용할 수 있는 모델은 시간과 비용이 많이 소요될 수 있는 더 많은 주석을 수집하는 데 대한 귀중한 대안을 제공합니다. 또한 상당한 감독이 가능한 경우에도 감독되지 않은 방식으로 좋은 표현을 학습하면 상당한 성능 향상을 제공할 수 있습니다. 지금까지 이에 대한 가장 설득력 있는 증거는 다양한 NLP 작업[8, 11, 26, 45]의 성능을 향상시키기 위해 사전 훈련된 단어 임베딩[10, 39, 42]을 광범위하게 사용했다는 것입니다.

그러나 레이블이 지정되지 않은 텍스트에서 단어 수준 이상의 정보를 활용하는 것은 두 가지 주요 이유로 어렵습니다. 첫째, 전송에 유용한 텍스트 표현을 학습하는 데 어떤 유형의 최적화 목표가 가장 효과적인지 불분명합니다. 최근 연구에서는 언어 모델링[44], 기계 번역[38], 담화 일관성[22]과 같은 다양한 목표를 조사했으며, 각 방법은 서로 다른 작업에서 다른 방법보다 성능이 뛰어납니다. 둘째, 가장 효과적인 방법에 대한 합의가 없습니다. 학습된 표현을 대상 작업으로 전송합니다. 기존 기술에는 모델 아키텍처에 대한 작업별 변경[43, 44], 복잡한 학습 체계 사용[21] 및 보조 학습 목표 추가[50]의 조합이 포함됩니다. 이러한 불확실성으로 인해 언어 처리를 위한 효과적인 준지도 학습 접근법을 개발하는 것이 어려워졌습니다.

본 논문에서는 비지도 사전 훈련과 지도 미세 조정의 조합을 사용하여 언어 이해 작업에 대한 준지도 접근 방식을 탐구합니다. 우리의 목표는 광범위한 작업에 거의 적응하지 않고 전환되는 보편적인 표현을 배우는 것입니다. 우리는 레이블이 지정되지 않은 대규모 텍스트 모음과 수동으로 주석이 달린 훈련 예제(대상 작업)가 있는 여러 데이터세트에 대한 액세스를 가정합니다. 우리의 설정에서는 이러한 대상 작업이 레이블이 없는 코퍼스와 동일한 도메인에 있을 필요가 없습니다. 우리는 2단계 교육 절차를 사용합니다. 먼저, 레이블이 지정되지 않은 데이터에 대한 언어 모델링 목표를 사용하여 신경망 모델의 초기 매개변수를 학습합니다. 그 후, 해당 감독 목표를 사용하여 이러한 매개 변수를 대상 작업에 적용합니다.

모델 아키텍처의 경우 기계 번역[62], 문서 생성[34] 및 구문 분석[29]과 같은 다양한 작업에서 강력한 성능을 발휘하는 것으로 알려진 Transformer[62]를 사용합니다. 이 모델 선택은 순환 네트워크와 같은 대안에 비해 텍스트의 장기 종속성을 처리하기 위한 보다 구조화된 메모리를 제공하여 다양한 작업 전반에 걸쳐 강력한 전송 성능을 제공합니다. 전송 중에 구조화된 텍스트 입력을 단일 연속 토큰 시퀀스로 처리하는 순회 스타일 접근 방식[52]에서 파생된 작업별 입력 적응을 활용합니다. 실험에서 보여주듯이 이러한 적응을 통해 사전 훈련된 모델의 아키텍처를 최소한으로 변경하면서 효과적으로 미세 조정할 수 있습니다.

우리는 자연어 추론, 질문 응답, 의미 유사성 및 텍스트 분류의 네 가지 유형의 언어 이해 작업에 대한 접근 방식을 평가합니다. 우리의 일반적인 작업 불가지론 모델은 각 작업에 맞게 특별히 제작된 아키텍처를 사용하는 차별적으로 훈련된 모델보다 성능이 뛰어나며 연구된 12개 작업 중 9개 작업에서 최첨단 수준을 크게 향상시킵니다. 예를 들어, 우리는 상식 추론(Stories Cloze Test)[40]에서 8.9%, 질문 답변(RACE)[30]에서 5.7%, 텍스트 수반(MultiNLI)[66]에서 5.5%의 절대적 개선을 달성했습니다. 최근 GLUE 다중 작업 벤치마크를 도입했습니다[64]. 또한 네 가지 다른 설정에서 사전 훈련된 모델의 제로샷 동작을 분석하고 다운스트림 작업에 유용한 언어 지식을 획득한다는 것을 보여주었습니다.

2. 관련 작업

NLP를 위한 준지도 학습 우리의 작업은 대체로 자연어에 대한 준지도 학습 범주에 속합니다. 이 패러다임은 서열 라벨링[24, 33, 57] 또는 텍스트 분류[41, 70]와 같은 작업에 적용되면서 상당한 관심을 끌었습니다. 초기 접근 방식은 레이블이 지정되지 않은 데이터를 사용하여 단어 수준 또는 구문 수준 통계를 계산한 다음 지도 모델의 기능으로 사용했습니다[33]. 지난 몇 년 동안 연구자들은 라벨이 지정되지 않은 말뭉치에 대해 훈련된 단어 임베딩[11, 39, 42]을 사용하여 다양한 작업의 성능을 향상시키는 이점을 입증했습니다[8, 11, 26, 45]. 그러나 이러한 접근 방식은 주로 단어 수준 정보를 전송하는 반면, 우리는 더 높은 수준의 의미를 포착하는 것을 목표로 합니다.

최근 접근 방식에서는 레이블이 지정되지 않은 데이터에서 단어 수준 이상의 의미를 학습하고 활용하는 방법을 조사했습니다. 레이블이 지정되지 않은 코퍼스를 사용하여 훈련할 수 있는 구문 수준 또는 문장 수준 임베딩은 텍스트를 다양한 대상 작업에 적합한 벡터 표현으로 인코딩하는 데 사용되었습니다[28, 32, 1, 36, 22, 12, 56, 31]

비지도 사전 훈련 비지도 사전 훈련은 지도 학습 목표를 수정하는 대신 좋은 초기화 지점을 찾는 것이 목표인 준지도 학습의 특별한 경우입니다. 초기 연구에서는 이미지 분류[20, 49, 63] 및 회귀 작업[3]에서 이 기술의 사용을 탐구했습니다. 후속 연구[15]에서는 사전 훈련이 정규화 방식으로 작용하여 심층 신경망에서 더 나은 일반화가 가능하다는 것을 보여주었습니다. 최근 연구에서 이 방법은 이미지 분류[69], 음성 인식[68], 엔터티 명확화[17] 및 기계 번역[48]과 같은 다양한 작업에서 심층 신경망을 훈련하는 데 도움이 되었습니다.

우리 작업에 가장 가까운 작업 라인은 언어 모델링 목표를 사용하여 신경망을 사전 훈련한 다음 감독을 통해 대상 작업에 맞게 미세 조정하는 것입니다. Daiet al. [13]과 Howard 및 Ruder [21]는 텍스트 분류를 개선하기 위해 이 방법을 따릅니다. 그러나 사전 훈련 단계는 일부 언어 정보를 캡처하는 데 도움이 되지만 LSTM 모델을 사용하면 예측 능력이 짧은 범위로 제한됩니다. 대조적으로, 우리가 선택한 변환기 네트워크를 사용하면 실험에서 입증된 것처럼 더 긴 범위의 언어 구조를 캡처할 수 있습니다. 또한 자연어 추론, 의역 감지, 스토리 완성 등 광범위한 작업에 대한 모델의 효율성도 입증합니다. 다른 접근법[43, 44, 38]은 사전 훈련된 언어 또는 기계 번역 모델의 숨겨진 표현을 보조 기능으로 사용하는 동시에 대상 작업에 대한 지도 모델을 훈련합니다. 여기에는 각각의 개별 대상 작업에 대한 상당한 양의 새로운 매개변수가 포함되는 반면, 전송 중에 모델 아키텍처에 대한 변경은 최소화됩니다.

보조 훈련 목표 보조 비지도 훈련 목표를 추가하는 것은 준지도 학습의 대체 형태입니다. Collobert와 Weston[10]의 초기 작업에서는 의미론적 역할 레이블 지정을 개선하기 위해 POS 태깅, 청킹, 명명된 엔터티 인식 및 언어 모델링과 같은 다양한 보조 NLP 작업을 사용했습니다. 최근 Rei [50]는 목표 작업 목표에 보조 언어 모델링 목표를 추가하고 시퀀스 레이블링 작업에서 성능 향상을 입증했습니다. 우리의 실험은 또한 보조 목표를 사용하지만, 우리가 보여주듯이 감독되지 않은 사전 훈련은 이미 목표 작업과 관련된 여러 언어적 측면을 학습합니다.

3 프레임워크

우리의 훈련 절차는 두 단계로 구성됩니다. 첫 번째 단계는 대규모 텍스트 모음에서 대용량 언어 모델을 학습하는 것입니다. 그 다음에는 레이블이 지정된 데이터를 사용하여 식별 작업에 모델을 적용하는 미세 조정 단계가 이어집니다.

3.1 감독되지 않은 사전 훈련

감독되지 않은 토큰 코퍼스 U = {u1, . . . , un}, 표준 언어 모델링 목표를 사용하여 다음 가능성을 최대화합니다.

여기서 k는 컨텍스트 창의 크기이고 조건부 확률 P는 매개변수 Θ가 있는 신경망을 사용하여 모델링됩니다. 이러한 매개변수는 확률적 경사 하강법을 사용하여 훈련됩니다[51].

우리 실험에서는 언어 모델로 Transformer [62]의 변형인 다층 Transformer 디코더 [34]를 사용했습니다. 이 모델은 입력 컨텍스트 토큰에 대해 다중 방향 self-attention 작업을 적용한 다음 위치별 피드포워드 레이어를 적용하여 대상 토큰에 대한 출력 분포를 생성합니다.

여기서 U = (u-k,...,u-1)은 토큰의 컨텍스트 벡터이고, n은 레이어 수, We는 토큰 임베딩 행렬, Wp는 위치 임베딩 행렬입니다.

3.2 감독된 미세 조정

"Eq. 1"의 목표를 사용하여 모델을 훈련한 후 감독 대상 작업에 매개변수를 적용합니다. 각 인스턴스가 레이블 y와 함께 일련의 입력 토큰 "x1, . . . , xm"으로 구성되는 레이블이 지정된 데이터 세트 C를 가정합니다. 입력은 사전 훈련된 모델을 통해 전달되어 최종 변환기 블록의 활성화 hl^m을 얻은 다음 y를 예측하기 위해 매개변수 Wy가 있는 추가 선형 출력 레이어에 공급됩니다.

이는 우리에게 다음과 같은 최대화 목표를 제공합니다.

또한 우리는 미세 조정에 대한 보조 목표로 언어 모델링을 포함시키는 것이 (a) 지도 모델의 일반화를 개선하고 (b) 수렴을 가속화함으로써 학습에 도움이 된다는 것을 발견했습니다. 이는 이러한 보조 목적으로 향상된 성능을 관찰한 이전 연구[50, 43]와 일치합니다. 구체적으로 다음 목표를 최적화합니다(가중치 λ 사용).

전반적으로 미세 조정 중에 필요한 유일한 추가 매개변수는 Wy와 구분 기호 토큰에 대한 임베딩입니다(아래 섹션 3.3에서 설명).

그림 1: (왼쪽) 이 작업에 사용된 Transformer 아키텍처 및 교육 목표. (오른쪽) 다양한 작업의 미세 조정을 위한 입력 변환. 모든 구조화된 입력을 토큰 시퀀스로 변환하여 사전 학습된 모델에서 처리한 다음 선형+소프트맥스 레이어를 처리합니다.

3.3 작업별 입력 변환

텍스트 분류와 같은 일부 작업의 경우 위에서 설명한 대로 모델을 직접 미세 조정할 수 있습니다. 질문 답변 또는 텍스트 수반과 같은 특정 작업에는 순서가 지정된 문장 쌍 또는 문서, 질문 및 답변의 세 쌍과 같은 구조화된 입력이 있습니다. 사전 훈련된 모델 이후 연속된 텍스트 시퀀스에 대해 학습되었으므로 이러한 작업에 적용하려면 몇 가지 수정이 필요합니다. 이전 연구에서는 전송된 표현 위에 학습 작업별 아키텍처를 제안했습니다[44]. 이러한 접근 방식은 상당한 양의 작업별 사용자 정의를 다시 도입하고 이러한 추가 아키텍처 구성 요소에 대해 전이 학습을 사용하지 않습니다. 대신에 우리는 구조화된 입력을 사전 훈련된 모델이 처리할 수 있는 순서가 지정된 시퀀스로 변환하는 순회 스타일 접근 방식[52]을 사용합니다. 이러한 입력 변환을 통해 작업 전반에 걸쳐 아키텍처를 광범위하게 변경하는 것을 피할 수 있습니다. 아래에서는 이러한 입력 변환에 대한 간략한 설명을 제공하며 그림 1은 시각적 설명을 제공합니다. 모든 변환에는 무작위로 초기화된 시작 및 종료 토큰(<s>, <e>) 추가가 포함됩니다.

텍스트 수반 수반 작업의 경우 전제 p와 가설 h 토큰 시퀀스를 사이에 구분 기호 토큰($)을 사용하여 연결합니다.

유사성 유사성 작업의 경우 비교되는 두 문장의 고유한 순서가 없습니다. 이를 반영하기 위해 입력 시퀀스를 수정하여 가능한 문장 순서(사이에 구분 기호 포함)를 모두 포함하고 각각을 독립적으로 처리하여 선형 출력 레이어에 공급되기 전에 요소별로 추가되는 두 개의 시퀀스 표현 hl^m을 생성합니다.

질문 응답 및 상식 추론 이러한 작업을 위해 컨텍스트 문서 z, 질문 q 및 가능한 답변 세트 {ak}가 제공됩니다. 문서 컨텍스트와 질문을 가능한 각 답변과 연결하고 그 사이에 구분 기호 토큰을 추가하여 [z; q; $; ak]. 이러한 각 시퀀스는 모델과 독립적으로 처리된 다음 소프트맥스 레이어를 통해 정규화되어 가능한 답변에 대한 출력 분포를 생성합니다.

4 실험

4.1 설정

감독되지 않은 사전 훈련 우리는 언어 모델 훈련을 위해 BooksCorpus 데이터 세트 [71]를 사용합니다. 모험, 판타지, 로맨스 등 다양한 장르의 독특한 미출판 도서 7,000권이 포함되어 있습니다. 결정적으로, 여기에는 긴 연속 텍스트가 포함되어 있어 생성 모델이 장거리 정보를 조건으로 하는 방법을 학습할 수 있습니다. 비슷한 접근 방식인 ELMo[44]에서 사용되는 대체 데이터 세트인 1B Word Benchmark는 크기는 거의 같지만 문장 수준에서 섞이므로 장거리 구조가 파괴됩니다. 우리의 언어 모델은 이 코퍼스에서 18.4라는 매우 낮은 토큰 수준의 혼란을 달성합니다.

표 1: 실험에 사용된 다양한 작업 및 데이터 세트 목록

모델 사양 우리 모델은 원래의 변압기 작업을 크게 따랐습니다[62]. 우리는 마스크된 self-attention 헤드(768차원 상태 및 12개 attention 헤드)가 있는 12층 디코더 전용 변환기를 훈련했습니다. 위치별 피드포워드 네트워크의 경우 3072차원 내부 상태를 사용했습니다. 우리는 최대 학습률이 2.5e-4인 Adam 최적화 체계 [27]를 사용했습니다. 학습률은 처음 2000번의 업데이트 동안 0에서 선형적으로 증가했으며 코사인 일정을 사용하여 0으로 어닐링되었습니다. 무작위로 샘플링된 64개의 미니배치, 512개 토큰의 연속 시퀀스에 대해 100세대 동안 훈련합니다. layernorm [2]는 모델 전반에 걸쳐 광범위하게 사용되므로 N(0, 0.02)의 간단한 가중치 초기화로 충분합니다. 우리는 정규화를 위해 40,000개의 병합[53]과 잔여, 임베딩 및 주의 드롭아웃 비율이 0.1인 바이트쌍 인코딩(BPE) 어휘를 사용했습니다. 우리는 또한 모든 비편향 또는 이득 가중치에 대해 w = 0.01인 [37]에서 제안된 L2 정규화의 수정된 버전을 사용했습니다. 활성화 함수로는 GELU(Gaussian Error Linear Unit)[18]를 사용했습니다. 우리는 원래 작업에서 제안된 정현파 버전 대신 학습된 위치 임베딩을 사용했습니다. 우리는 ftfy 라이브러리를 사용하여 BooksCorpus의 원시 텍스트를 정리하고 일부 구두점과 공백을 표준화하며 spaCy 토크나이저를 사용합니다.

세부 조정 지정하지 않는 한, 감독되지 않은 사전 훈련의 하이퍼파라미터 설정을 재사용합니다. 0.1의 비율로 분류기에 드롭아웃을 추가합니다. 대부분의 작업에 대해 우리는 6.25e-5의 학습률과 32의 배치 크기를 사용합니다. 우리의 모델은 빠르게 미세 조정되었으며 대부분의 경우 3번의 훈련으로 충분했습니다. 훈련의 0.2%가 넘는 워밍업이 포함된 선형 학습률 감소 일정을 사용합니다. λ는 0.5로 설정되었습니다.

4.2 감독된 미세 조정

자연어 추론, 질문 답변, 의미 유사성, 텍스트 분류 등 다양한 지도 작업에 대한 실험을 수행합니다. 이러한 작업 중 일부는 우리가 활용하는 최근 출시된 GLUE 다중 작업 벤치마크[64]의 일부로 제공됩니다. 그림 1은 모든 작업과 데이터 세트의 개요를 제공합니다.

자연어 추론 텍스트 수반 인식이라고도 알려진 자연어 추론(NLI) 작업에는 한 쌍의 문장을 읽고 수반, 모순 또는 중립 중 하나에서 문장 간의 관계를 판단하는 작업이 포함됩니다. 최근 많은 관심이 있었지만 [58, 35, 44], 어휘 수반, 상호 참조, 어휘 및 구문 모호성과 같은 다양한 현상이 존재하기 때문에 작업은 여전히 어려운 과제입니다. 우리는 이미지 캡션(SNLI), 전사된 연설, 대중 소설, 정부 보고서(MNLI), Wikipedia 기사(QNLI), 과학 시험(SciTail) 또는 뉴스 기사(RTE)를 포함한 다양한 소스를 갖춘 5개의 데이터 세트를 평가합니다.

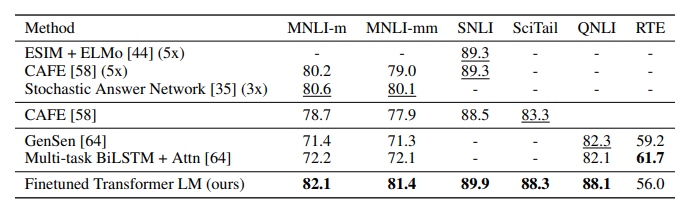

표 2는 우리 모델과 이전의 최첨단 접근 방식에 대한 다양한 NLI 작업에 대한 다양한 결과를 자세히 설명합니다. 우리의 방법은 5개 데이터 세트 중 4개에 대한 기준보다 훨씬 뛰어난 성능을 발휘하여 이전 최고 결과에 비해 MNLI에서 최대 1.5%, SciTail에서 5%, QNLI에서 5.8%, SNLI에서 0.6%의 절대적인 개선을 달성했습니다. 이는 여러 문장에 대해 더 나은 추론을 수행하고 언어적 모호함의 측면을 처리하는 모델의 능력을 보여줍니다. 우리가 평가하는 소규모 데이터세트 중 하나인 RTE(예제 2490개)에서는 56%의 정확도를 달성했는데, 이는 다중 작업 biLSTM 모델에서 보고한 61.7%보다 낮습니다. 더 큰 NLI 데이터 세트에 대한 우리 접근 방식의 강력한 성능을 고려할 때 우리 모델은 다중 작업 훈련에서도 이점을 얻을 가능성이 높지만 현재는 이에 대해 조사하지 않았습니다.

표 2: 자연어 추론 작업에 대한 실험 결과, 우리 모델을 현재 최첨단 방법과 비교합니다. 5x는 5개 모델의 앙상블을 나타냅니다. 모든 데이터 세트는 정확도를 평가 지표로 사용합니다.

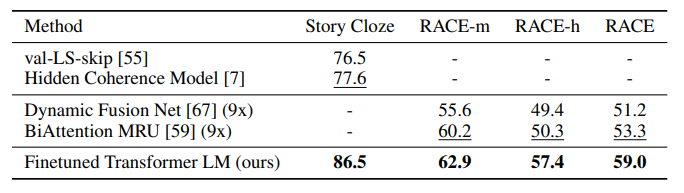

표 3: 우리 모델과 현재의 최신 방법을 비교한 질문 답변 및 상식 추론 결과. 9x는 9개 모델의 앙상블을 의미합니다.

질문 응답 및 상식 추론 단일 및 다중 문장 추론 측면이 필요한 또 다른 작업은 질문 응답입니다. 우리는 중학교 및 고등학교 시험과 관련된 질문이 있는 영어 지문으로 구성된 최근 발표된 RACE 데이터세트[30]를 사용합니다. 이 코퍼스에는 CNN[19] 또는 SQuaD[47]와 같은 다른 데이터 세트보다 더 많은 추론 유형 질문이 포함되어 장거리 컨텍스트를 처리하도록 훈련된 모델에 대한 완벽한 평가를 제공하는 것으로 나타났습니다. 또한 두 가지 옵션 중에서 여러 문장으로 구성된 이야기의 올바른 결말을 선택하는 Story Cloze Test[40]를 평가합니다. 이러한 작업에서 우리 모델은 Story Cloze에서 최대 8.9%, RACE에서 전체 5.7%의 상당한 마진으로 이전의 최고 결과를 다시 능가합니다. 이는 장거리 상황을 효과적으로 처리하는 모델의 능력을 보여줍니다.

의미 유사성 의미 유사성(또는 의역 감지) 작업에는 두 문장이 의미상 동일한지 여부를 예측하는 작업이 포함됩니다. 문제는 개념의 변경을 인식하고, 부정을 이해하고, 구문적 모호성을 처리하는 데 있습니다. 이 작업에는 MRPC(Microsoft Paraphrase corpus)[14](뉴스 소스에서 수집), QQP(Quora Question 쌍) 데이터 세트[9] 및 STS-B(의미적 텍스트 유사성 벤치마크)의 세 가지 데이터 세트를 사용합니다.

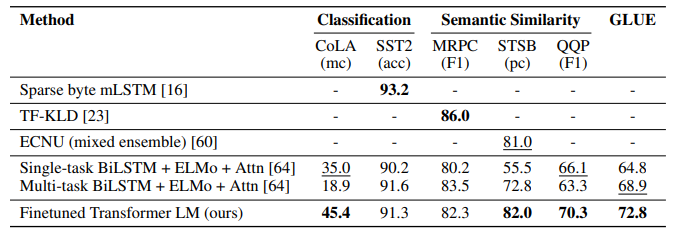

우리는 STS-B에서 1포인트 절대 이득을 사용하여 세 가지 의미 유사성 작업 중 두 가지(표 4)에 대한 최첨단 결과를 얻었습니다. QQP의 성능 차이는 상당하며 단일 작업 BiLSTM + ELMo + Attn에 비해 4.2% 절대적인 향상이 있습니다.

분류 마지막으로 두 가지 다른 텍스트 분류 작업에 대해서도 평가합니다. CoLA(언어적 수용성 코퍼스) [65]에는 문장이 문법적인지 여부에 대한 전문가 판단이 포함되어 있으며 훈련된 모델의 타고난 언어적 편향을 테스트합니다. 반면에 Stanford Sentiment Treebank(SST-2)[54]는 표준 이진 분류 작업입니다. 우리 모델은 CoLA에서 45.4점을 얻었는데, 이는 이전의 최고 결과인 35.0보다 특히 큰 도약으로, 우리 모델이 학습한 타고난 언어적 편견을 보여줍니다. 이 모델은 SST-2에서도 91.3%의 정확도를 달성해 최첨단 결과와 경쟁력을 갖췄다. 또한 GLUE 벤치마크에서 전체 점수 72.8점을 달성했는데, 이는 이전 최고 점수인 68.9점보다 훨씬 향상된 수치입니다.

표 4: 우리 모델을 현재 최첨단 방법과 비교한 의미론적 유사성 및 분류 결과. 이 표의 모든 작업 평가는 GLUE 벤치마크를 사용하여 수행되었습니다. (mc= 매튜스 상관관계, acc=정확도, pc=피어슨 상관관계)

전반적으로 우리의 접근 방식은 평가 대상인 12개 데이터 세트 중 9개에서 새로운 최첨단 결과를 달성했으며 많은 경우 앙상블보다 뛰어난 성능을 보였습니다. 우리의 결과는 또한 우리의 접근 방식이 STS-B(5.7k 훈련 예제)와 같은 작은 데이터 세트부터 가장 큰 SNLI(550k 훈련 예제)에 이르기까지 다양한 크기의 데이터 세트에서 잘 작동한다는 것을 나타냅니다.

5 분석

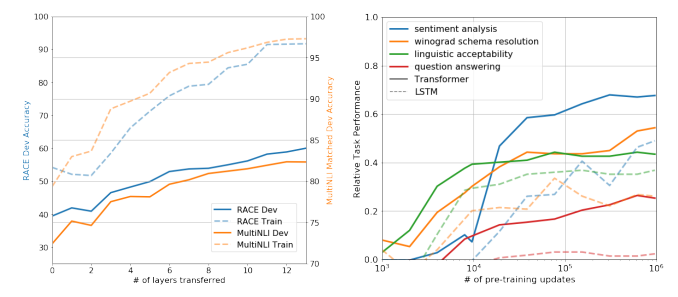

전송된 레이어 수의 영향 우리는 감독되지 않은 사전 훈련에서 감독된 대상 작업으로 다양한 수의 레이어를 전송하는 것의 영향을 관찰했습니다. 그림 2(왼쪽)는 전송된 레이어 수에 따른 MultiNLI 및 RACE 접근 방식의 성능을 보여줍니다. 우리는 임베딩을 전송하면 성능이 향상되고 각 변환기 레이어는 MultiNLI의 전체 전송에 대해 최대 9%의 추가 이점을 제공한다는 표준 결과를 관찰했습니다. 이는 사전 훈련된 모델의 각 계층에 목표 작업을 해결하는 데 유용한 기능이 포함되어 있음을 나타냅니다.

그림 2: (왼쪽) RACE 및 MultiNLI에 대한 사전 학습된 언어 모델에서 점점 더 많은 수의 레이어를 전송하는 효과. (오른쪽) LM 사전 훈련 업데이트의 기능으로 다양한 작업에서 제로샷 성능의 진화를 보여주는 플롯. 작업당 성능은 단일 모델을 사용하여 무작위 추측 기준과 현재 최첨단 사이에서 정규화됩니다.

제로샷 동작 우리는 변환기의 언어 모델 사전 훈련이 효과적인 이유를 더 잘 이해하고 싶습니다. 가설은 기본 생성 모델이 언어 모델링 기능을 향상시키기 위해 우리가 평가하는 많은 작업을 수행하는 방법을 학습하고 변환기의 보다 구조화된 주의 기억이 LSTM에 비해 전송을 지원한다는 것입니다. 우리는 감독된 미세 조정 없이 작업을 수행하기 위해 기본 생성 모델을 사용하는 일련의 경험적 솔루션을 설계했습니다. 우리는 그림 2(오른쪽)에서 생성적 사전 훈련 과정에서 이러한 경험적 솔루션의 효율성을 시각화합니다. 우리는 이러한 경험적 방법의 성능이 훈련에 비해 안정적이고 꾸준히 증가한다는 것을 관찰했습니다. 이는 생성적 사전 훈련이 다양한 작업 관련 기능의 학습을 지원한다는 것을 시사합니다. 또한 LSTM이 제로 샷 성능에서 더 높은 분산을 나타내는 것을 관찰했는데, 이는 Transformer 아키텍처의 유도 바이어스가 전송을 돕는다는 것을 의미합니다.

표 5: 다양한 작업에 대한 다양한 모델 절제 분석. 평균 점수는 모든 결과의 비가중 평균입니다. (mc= 매튜스 상관관계, acc=정확도, pc=피어슨 상관관계)

CoLA(언어적 수용성)의 경우 예제는 생성 모델이 할당하는 평균 토큰 로그 확률로 점수가 매겨지고 예측은 임계값에 의해 이루어집니다. SST-2(감정 분석)의 경우 각 예에 토큰을 매우 추가하고 언어 모델의 출력 분포를 긍정적이고 부정적인 단어로만 제한하고 더 높은 확률을 예측으로 할당하는 토큰을 추측합니다. RACE(질문 응답)의 경우 생성 모델이 문서 및 질문에 대해 조건을 지정할 때 가장 높은 평균 토큰 로그 확률을 할당하는 답변을 선택합니다. DPRD [46](winograd 스키마)의 경우, 우리는 명확한 대명사를 두 개의 가능한 참조로 대체하고 생성 모델이 대체 후 나머지 시퀀스에 더 높은 평균 토큰 로그 확률을 할당하는 해결 방법을 예측합니다.

절제 연구 우리는 세 가지 다른 절제 연구를 수행합니다(표 5). 먼저, 미세 조정 중에 보조 LM 대물렌즈 없이 방법의 성능을 검사합니다. 우리는 보조 목표가 NLI 작업과 QQP에 도움이 된다는 것을 관찰합니다. 전반적으로 추세는 더 큰 데이터 세트가 보조 목표의 이점을 누리지만 더 작은 데이터 세트는 그렇지 않다는 것을 시사합니다. 둘째, 동일한 프레임워크를 사용하는 단일 레이어 2048 단위 LSTM과 비교하여 Transformer의 효과를 분석합니다. Transformer 대신 LSTM을 사용할 때 평균 점수가 5.6 하락하는 것을 관찰했습니다. LSTM은 MRPC라는 하나의 데이터세트에서만 Transformer보다 성능이 뛰어납니다. 마지막으로 사전 훈련 없이 지도 대상 작업에 대해 직접 훈련된 변환기 아키텍처와도 비교합니다. 사전 훈련이 부족하면 모든 작업에서 성능이 저하되어 전체 모델에 비해 14.8% 감소하는 것으로 나타났습니다.

6 결론

우리는 생성적 사전 훈련과 차별적인 미세 조정을 통해 단일 작업 불가지론 모델로 강력한 자연어 이해를 달성하기 위한 프레임워크를 도입했습니다. 긴 연속 텍스트가 포함된 다양한 코퍼스에 대한 사전 훈련을 통해 우리 모델은 중요한 세계 지식과 장거리 종속성을 처리할 수 있는 능력을 습득한 다음 질문 답변, 의미 유사성 평가, 수반 결정, 텍스트 분류를 통해 우리가 연구하는 12개 데이터 세트 중 9개에 대한 최신 기술을 개선했습니다. 감독되지 않은 (사전) 훈련을 사용하여 판별 작업의 성능을 높이는 것은 오랫동안 기계 학습 연구의 중요한 목표였습니다. 우리의 연구는 상당한 성능 향상을 달성하는 것이 실제로 가능하다는 것을 시사하고 이 접근 방식에 가장 적합한 모델(변환기) 및 데이터 세트(장거리 종속성이 있는 텍스트)에 대한 힌트를 제공합니다. 우리는 이것이 자연어 이해 및 기타 영역 모두에 대한 비지도 학습에 대한 새로운 연구를 가능하게 하고 비지도 학습이 언제 어떻게 작동하는지에 대한 이해를 더욱 향상시키는 데 도움이 되기를 바랍니다.

'자연어처리논문' 카테고리의 다른 글

| RoBERTa 논문 리뷰 (0) | 2023.12.03 |

|---|---|

| [번역] RoBERTa: A Robustly Optimized BERT Pretraining Approach (2) | 2023.12.03 |

| [번역] Neural Machine Translation by Jointly Learning to Align and Translate (0) | 2023.11.04 |

| Sequence to Sequence 논문 리뷰 (0) | 2023.10.26 |

| ELMo 논문 요약 (0) | 2023.10.14 |